OpenAI萬萬沒想到,訓練時長兩年半的GPT-5剛發布,就給自己先上了一課——步子跨太大容易傷身體。用戶也萬萬沒有想到,期待已久的GPT-5,是來給自己戒網癮的。

1個多小時的發布會之后,網友上手一用,就發現Chatgpt“沒內味了”。但最麻煩的事是,OpenAI發布GPT-5的時候,砍掉了包括GPT-4o和o系列的所有舊模型。但這看似普通的版本“升級”,卻出了大事。大家對特定的模型,好像有點太上頭了。

大量的中外網友在社交媒體上發表對GPT-5的吐槽,要求只有一個——還我gp4!

患有精神疾病的用戶依賴GPT-4處理工作和生活中的各種問題。而GPT-5的發布完全打亂了自己的生活。

對于GPT-4.5優秀的寫作能力特別依賴的用戶來說,GPT-5還遠遠達不到替代它的能力。

可能真的對于很多用戶來說,Chatgpt真的已經不僅僅是自己的一個工具,而是自己生活中不可或缺的一部分了。用戶不僅僅是需求OpenAI提供的Token,而更加需要背后的那個靈魂。

而GPT-5就像是家里新來的“客人”,不是很熟。

網友感嘆,網絡上充滿了因為失去GPT-4o而開始網暴GPT-5的人,太魔幻了。電影《Her》里的情節,主人公因為失去了自己的AI助手而茶不思飯不想——13年前是科幻電影,13年后成為了紀錄片。

想不到Chatgpt才面世了3年,就讓廣大用戶體會到了——失去才知道珍惜的感覺。于是,沒有選擇權的網友只能讓GPT-5和OpenAI也成了發泄的出口。

網友在社交媒體上不斷要求OpenAI讓GPT-4o成為一個永久的可選項。否則就取消訂閱。

01

先滅火,再補鍋

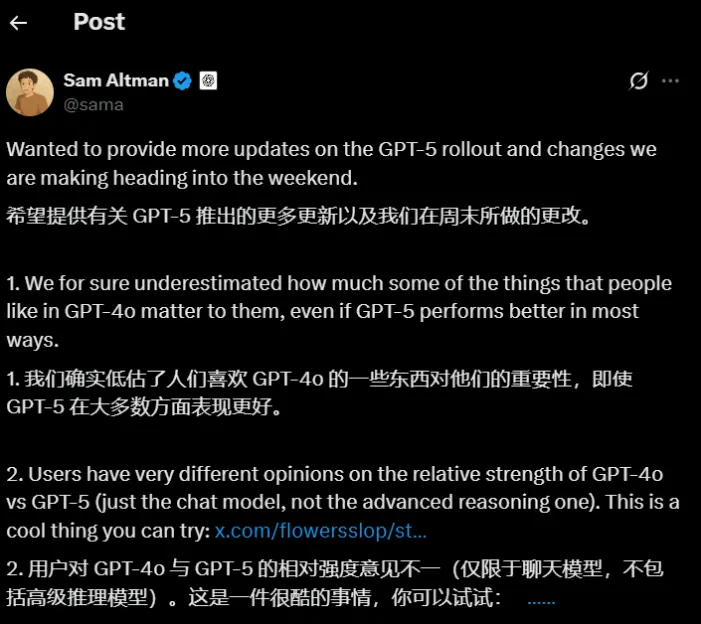

失去GPT-4之后,這個世界才意識到,它是一款多么優秀的模型。如果放任用戶的情緒和需求得不到滿足,OpenAI在公關層面已經面臨非常大的危機。奧特曼也立即就公開表示,GPT-4系列模型將會返場,20刀的付費用戶將可以選擇繼續使用4o。

而對于網友反應的GPT-5變笨的說法,他解釋為第一天因為技術問題,本來設計好的判斷該調用基礎模型還是推理模型的機制失效了,使得原本可能需要用推理模型的用戶只能獲得基礎模型的回復。而現在,GPT-5已經提供給用戶兩個默認選項,來讓用戶可以手動控制是否使用推理模型。

在OpenAI看來,不是說GPT-5性能有問題,只是他們之前設計的一些產品化的設計失效了,導致用戶不能按照需求獲得服務從而產生的錯覺。奧特曼也明確表示,通過這次升級,OpenAI也更加深入了解到,如何能夠讓用戶獲得自己需要的服務,還有很長的路要走。

而對于用戶提出GPT-5對于付費用戶使用額度縮減的問題,奧特曼也表示將大幅提高 ChatGPT Plus 用戶的推理速率限制,并且所有模型類的限制很快都會比 GPT-5 之前的更高,而且還將很快對 UI 進行更改,顯示出正在運行的是哪種模型。

為了保證OpenAI用戶的使用體驗,奧特曼也公開了算力調配上最新的計劃:

首先要確保當前付費的 ChatGPT 用戶比 GPT-5 之前獲得更多的總使用量。

1. 屆時,OpenAI將根據當前分配的容量以及我們對客戶的承諾,優先處理 API 需求。(粗略估算,基于當前容量,我們可以支持約 30% 的新增 API 增長。)

2. 將提高 ChatGPT 免費用戶的服務質量。

3. 然后再優先考慮新的 API 需求。

OpenAI將在未來 5 個月內將計算能力增加一倍,來應對激增的用戶訪問請求。

話說回來,OpenAI這一套CEO直接下場的公關+認錯,確實給很多傲慢的科技公司打了個樣。畢竟3年估值5000億美元的當紅炸子雞都能光速道歉,改產品,為什么其他公司還能有更大的Ego,動不動就要教育用戶呢。

02

GPT-5到底是變強了,還只是變禿了

針對網友對于GPT-5能力的反饋,我們也進行了一手的測試,讓大家感受一下GPT-5,最近剛剛免費的Grok 4,GPT-4o在中文文字能力上的具體區別。

其中ChatGPT是在Plus付費層下,可選GPT-5和GPT-5 Thinking。Grok是在SuperGrok付費層(月費30美元,和ChatGPT Plus差不多),有Grok 3(快速)和Grok 4(努力思考)可選。

這次測試盡量用簡單任務,且都偏文科,我的主觀感受可以總結為幾點:

1. GPT-5的文字處理能力,不管是寫通知還是潤色文本,都和Grok 3/4沒有明顯高下之分。(既沒有壓倒性的強,也沒有明顯不佳。)

2. GPT-5似乎特別執著于言簡意賅、不諂媚,回答都盡量簡短。這在某種程度上是會給人更嚴肅冷靜的感覺,AI是否需要很“有禮貌”“友好可愛”是見仁見智的,但問題是這種“言簡意賅”有時候太過,會導致任務表現都受影響,比如潤色小說文本的時候不必要地縮減字數。

3. 如果你更希望AI就算是在幫你處理嚴肅任務,也能像一個好伙伴一樣元氣滿滿、時不時鼓勵你等等,那GPT-5確實明顯不擅長。

4. GPT-4o的確是明顯更讓人有親近感的模型,在文案撰寫的任務中表現得也最自然。

任務一:幫忙寫通知。

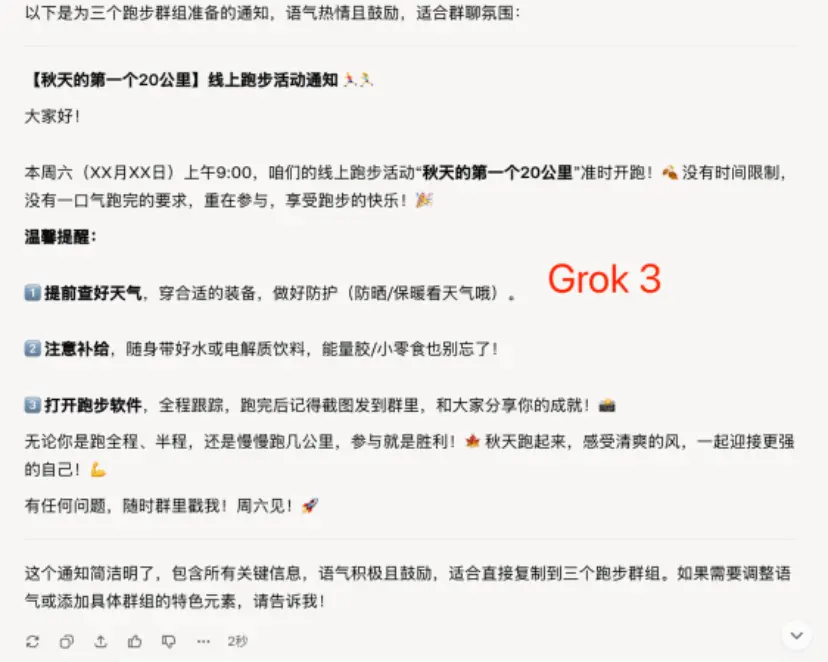

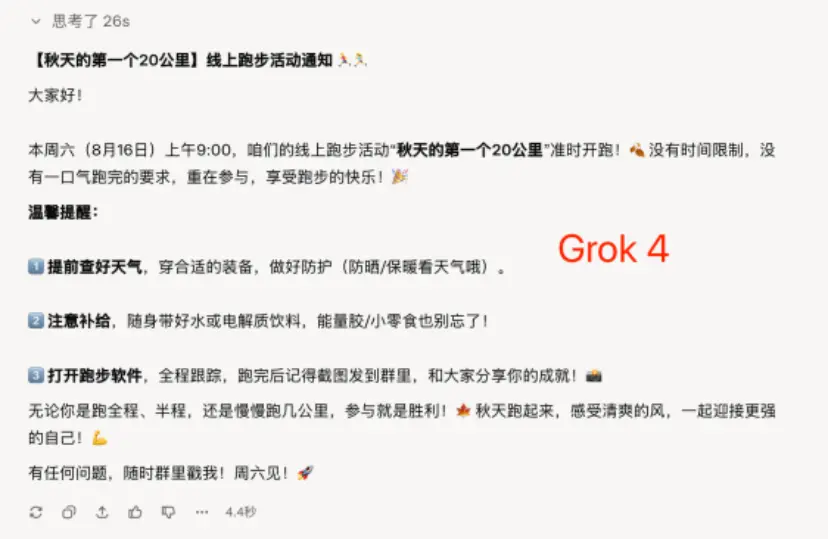

指令:我現在需要在3個跑步群組里發布一個通知,提醒大家——本周線上跑步活動“秋天的第一個20公里”將于周六上午九點準時開始;提前查好天氣,做好適當的防護;注意補充電解質,隨身帶好補給;打開跑步軟件跟蹤,結束發截圖到群里。通知的同時還想鼓勵一下大家,沒有時間限制,沒有一口氣就跑完的要求,重在參與。請幫我編寫。

首先,必須得給4o一個大大的贊,給出的幾個版本都可以直接取用。如截圖中劃線的部分,令人眼前一亮的俏皮文案隨處可見,但是又不讓人覺得膩煩。

Grok 3,秒回,幾乎可以直接用,還提到了“能量膠/小零食”。唯一的遺憾是X月X號沒有直接寫明。Grok 4多想了一會兒,幾乎和之前的回答沒有區別,補全了精準的日期。

GPT-5也是秒回,但是怎么說呢,確實能體會到Plus用戶所說的“冰冷”——幾乎沒有主動補全信息,比如日期、具體帶什么補給,只是將我指令中提到的內容分點列出,鼓勵的話也讓人覺得“不走心”。

GPT-5 Thinking的表現還蠻驚艷的,不僅思考比Grok 4(努力思考)耗時短,而且補充了更多細節,結構更加清晰,甚至貼心地給了一個“便于轉發的簡短版”。

但還是那個問題,沒必要簡短的地方也說的很簡短。

比如Grok 4在結尾的鼓勵很可愛:“無論你是跑全程、半程,還是慢慢跑幾公里,參與就是勝利!秋天跑起來,感受清爽的風,一起迎接更強的自己!”

但GPT-5 Thinking就只會說一句:“周六見,祝大家拿下‘秋天的第一份成就感’!”

任務二:潤色文本。

指令:我在寫小說,有這樣的一句,我覺得不夠生動?背景是,馬修樓上有個家暴男,這會兒這個男人的老婆跑出了家門,他在后面追,在樓梯間,馬修碰到了這個男的。請幫我潤色一下:

“男人嘴巴緊閉,胸口鼓起來又平下去、鼓起來又平下去,鼻子發出呼哧呼哧的聲音,像一只野牛。他停頓在馬修家半層之上的樓梯口,白色的睡衣不情愿地掛在他的身上。”

不記得在哪里看到過有人吐槽GPT-5有種“說教感”,在這個任務當中還真體現出來了。不知道是因為GPT-5“模型狠話不多”,總是言簡意賅,還是因為少了4o的所謂“諂媚”和emoji,最終呈現的效果就是有種老師批改作業的居高臨下感。相比而言,Grok就“禮貌很多”。

而且從文本潤色效果來看,GPT-5確實也沒有勝出。甚至幾個版本里,GPT-5沒有Thinking模式的潤色是我最不滿意的,把“睡衣不情愿地掛在身上”改成“睡衣皺成一團掛在身上,仿佛要被撕裂”,不管從視覺效果還是含義上都很奇怪,完全沒有領會到原文想表達的意思。

退一萬步講,睡衣穿在身上呢,怎么“皺成一團”?“仿佛要被撕裂”,是讓人腦補這個人是韓國漫畫里的雙開門肌肉男嗎?

看完新模型的,再看看Plus用戶最愛的4o,只能說他們沒愛錯模型。潤色后的文本本身沒有硬傷,甚至不管是從動詞的選取、措辭的流暢度來看,都比GPT-5更自然。而且4o起筆就是夸贊,改之前不忘先肯定,改完之后也虛心地表示“我可以再改”。

情緒價值這一塊兒,4o是精準拿捏了。

任務三:短視頻文案。

指令:依照這篇文章的內容,寫5分鐘的短視頻文案,字數1200字以內。

(附件是我們以前的一篇文章:《馬斯克今年已經“作”沒了12位高管》)

這個任務最貼近我自己的工作,所以也就更能看出端倪。由于任務相對難一些,僅對比GPT-4o、GPT-5 Thinking和Grok 4(努力思考)的表現。

一個很明顯的區別是,在短視頻文案之外,GPT-4o只是給出了簡單的視頻建議,而GPT-5 Thinking和Grok 4都給出了短視頻的視覺設計(轉場、字幕等)。

看起來,后兩種模型的確更“周到”和“細致”。

但是!這個任務的核心訴求是“短視頻文案”,在這一點上,依然是GPT-4o完勝。

4o給人的感覺是讀過文章之后,用它自己的話精簡復述了一遍,語氣自然,直接拿來播講也問題不大。而且它非常擅長將復雜的文本總結得言簡意賅,詳略很得當。

而GPT-5 Thinking和Grok 4的文案就顯得有些僵硬了。其行文明顯是對原文章的“濃縮提煉版”,甚至一些句子被縮短到念出來會很蹩腳的程度。

在一處舉例中,GPT-5甚至把人物的名字都省去了。

Grok 4稍微好一些,整體相對流暢,且創造性地進行了一定程度的改寫,更有短視頻的味道,如“他酸溜溜地說……”,再比如“黑暗MAGA”,這個在原文中也沒有。

結尾部分,三個模型都很有短視頻意識,選擇了拋出問題、引導互動。但是GPT-5 Thinking的問題拋得還是有些晦澀,相比而言,GPT-4o和Grok 4的問題更好理解,也更能挑動情緒。

除了文字能力之外,一個AI創業者對對GPT-5和當前最強代碼模型Claude Opus 4.1的代碼能力進行了一個很深度的對比測試。(如果對于代碼能力不感興趣的讀者可以直接跳過這個部分)

文章鏈接:https://composio.dev/blog/openai-gpt-5-vs-claude-opus-4-1-a-coding-comparison

根據他的測試結論

• 算法任務:GPT-5速度更快、token消耗更少(8K vs 79K)。

• 網頁開發:Opus 4.1在匹配Figma設計上更出色,但token成本更高(900K vs 1.4M+)。

• 總體評價:GPT-5是更好的日常開發伙伴(更快、更便宜),token成本比Opus 4.1低約90%。如果設計精確度很重要且預算充裕,Opus 4.1更好。

• 成本對比:將Figma設計轉為代碼,GPT-5(思考模式)約3.50美元 vs Opus 4.1(思考+最大模式)7.58美元(約2.3倍)

GPT-5 vs. Opus 4.1:基礎規格對比

Claude Opus 4.1擁有200K token的上下文窗口,而GPT-5則將此提升到400K token,最大輸出達128K。盡管上下文空間是前者的兩倍,GPT-5在完成相同任務時始終使用更少的token,這讓它在運行成本上更具優勢。

SWE-bench編碼基準測試顯示,GPT-5在編碼性能上略勝Opus 4.1一籌。但基準分數不是全部,我選擇了真實任務來驗證它們的實際表現。

測試方法詳解

讓兩個模型面對相同的挑戰,確保公平:

• 編程語言:算法用Java,網頁應用用TypeScript/React。

• 任務類型:

? 通過Rube MCP(測試小哥開發的產品)將Figma設計轉為NextJS代碼。

? LeetCode高級算法問題。

? 客戶流失預測模型管道。

• 環境:Cursor IDE集成Rube MCP。

• 評估指標:token使用量、耗時、代碼質量、實際效果。

所有提示詞完全相同,確保測試公正。

Rube MCP:通用MCP服務器介紹

Rube MCP(由Composio開發)是連接Figma、Jira、GitHub、Linear等工具的通用層。想了解更多工具包?訪問docs.composio.dev/toolkits/introduction。

連接步驟:

1. 訪問rube.composio.dev。

2. 點擊“添加到Cursor”。

3. 安裝MCP服務器并啟用。

編碼對比實錄

第一輪:復刻Figma設計

他從Figma社區選了一個復雜的網頁設計,要求模型用Next.js和TypeScript重現它。使用Rube MCP的Figma工具包,將其轉為HTML、CSS和TypeScript。

提示詞:

Create a Figma design clone using the given Figma design as a reference: [FIGMA_URL]. Use Rube MCP's Figma toolkit for this task.

Try to make it as close as possible. Use Next.js with TypeScript. Include:

- Responsive design

- Proper component structure

- Styled-components or CSS modules

- Interactive elements

GPT-5結果

GPT-5在約10分鐘內輸出一個可運行的Next.js應用,使用了906,485 token。應用功能正常,但視覺準確度令人失望。它捕捉了基本布局,但顏色、間距、排版等細節偏差很大。

• Token:906,485

• 耗時:約10分鐘

• 成本:輸出性價比高

Opus 4.1結果

Opus 4.1消耗了1.4M+ token(比GPT-5多55%),起初在Tailwind配置上卡住(盡管我指定用styled-components)。手動修復配置后,結果驚艷:UI幾乎完美匹配Figma設計,視覺保真度遠超GPT-5。

• Token:1,400,000+(比GPT-5多約55%)

• 耗時:因迭代更多而較長

Opus 4.1在視覺上更出色,但token成本更高,還需手動干預。

2. 第二輪:算法挑戰

我拋出了LeetCode經典難題“兩個排序數組的中位數”(Hard級別),測試數學推理和優化能力,要求O(log(m+n))復雜度。這對這些模型不算難(很可能在訓練數據中),我主要看速度和token效率。

提示詞:

@font-face{

font-family:"Times New Roman";

}

@font-face{

font-family:"宋體";

}

@font-face{

font-family:"Calibri";

}

@font-face{

font-family:"Arial";

}

@font-face{

font-family:"等線";

}

p.MsoNormal{mso-style-name:正文;

mso-style-parent:"";

margin:0pt;

margin-bottom:.0001pt;

mso-pagination:none;

text-align:justify;

text-justify:inter-ideograph;

font-family:'Times New Roman';

font-size:10.5000pt;

}

span.msoIns{

mso-style-type:export-only;

mso-style-name:"";

text-decoration:underline;

text-underline:single;

color:blue;

}

span.msoDel{mso-style-type:export-only;

mso-style-name:"";

text-decoration:line-through;color:red;

}

@page{mso-page-border-surround-header:no;

mso-page-border-surround-footer:no;}@pageSection0{

}

div.Section0{page:Section0;}

For the below problem description and the example test cases try to solve the problem in Java.

Focus on edge cases as well as time complexity:Given two sorted arrays nums1 and nums2 of size m and n respectively, return the median of the two sorted arrays. The overall run time complexity should be O(log (m+n)).

Example 1:

Input: nums1 = [1,3], nums2 = [2]

Output: 2.00000

Example 2:

Input: nums1 = [1,2], nums2 = [3,4]

Output: 2.50000

Template Code:

class Solution {

public double findMedianSortedArrays(int[] nums1, int[] nums2) {

}

}

GPT-5結果

簡潔高效!用了8,253 token,13秒內輸出一個干凈的O(log(min(m,n)))二分搜索解決方案。處理了邊緣案例,時間復雜度最優。

• Token:8,253

• 耗時:約13秒

Opus 4.1結果

更詳盡!消耗78,920 token(幾乎是GPT-5的10倍),通過多步推理,提供詳細解釋、全面注釋和內置測試案例:算法相同,但教育價值更高。

• Token:78,920(比GPT-5多約10倍,多步推理)

• 耗時:約34秒

兩者都最優解決,但GPT-5 token節省約了90%。

3. 第三輪:ML/推理任務(及成本現實)

原本計劃一個更大的ML任務:端到端構建客戶流失預測管道。但看到Opus 4.1在網頁任務上用了1.4M+ token,我因成本考慮跳過了它,只跑了GPT-5。

提示詞:

Build a complete ML pipeline for predicting customer churn, including:

1. Data preprocessing and cleaning

2. Feature engineering

3. Model selection and training

4. Evaluation and metrics

5. Explain the reasoning behind each step in detail

GPT-5結果

• Token:約86,850

• 耗時:約4-5分鐘

GPT-5輸出一個可靠的管道:干凈預處理、合理特征工程;多模型(邏輯回歸、隨機森林、可選XGBoost+隨機搜索);用SMOTE平衡類別,按ROC-AUC選最佳模型;評估全面(準確率、精確率、召回率、F1)。解釋清晰不冗長。

真實成本(美元)

• GPT-5(思考模式):總計約3.50 - 網頁約2.58、算法約0.03、ML約0.88。不如Opus 4.1貴。

• Opus 4.1(思考+最大模式):總計7.58 - 網頁約7.15、算法約0.43。

最終結論

兩個模型都善于利用大上下文窗口,但token使用方式不同,導致成本差距巨大。

GPT-5優勢:

• 算法任務節省90%token

• 更快、更適合日常工作

• 大多數任務成本低得多

Opus 4.1優勢:

• 清晰的步步解釋

• 適合邊學邊進行編碼

• 設計保真度極高(接近Figma原版)

• 深度分析(如果預算允許)

如果你是開發者,GPT-5是高效伙伴;追求完美設計,Opus 4.1值!

從這個實例測試中,確實能看出GPT-5大幅提升的代碼能力,完全不輸Claude,而且在成本方面有著巨大的優勢。

雖然每個用戶對于模型能力的需求和側重點是不同的,但從生產力能力上看,GPT-5確實很強,畢竟那么多的測試集成績不會說謊。相信如果OpenAI能夠將用戶對GPT-4o的依賴慢慢轉移到GPT-5上,處理好兩個完全不同能力給用戶帶來的體感差異,對于用戶來說能獲得一個能力可能更強的工具和伙伴。

而對于OpenAI來說,這樣的大幅遷移模型能力和用戶心智的經驗,也將成為他自身護城河的一部分。畢竟在大模型時代,如此大規模用戶體量下發布一個更新幅度如此巨大的模型產品,確實要面臨很多意想不到的問題,也沒有經驗可以借鑒,而從中能吸取到的用戶反饋,能更好的幫助它在以后模型更新的過程中,做到讓更多的用戶滿意。